前沿分享 |医学人工智能与临床决策的挑战与融合

分享者导读

本文深入探讨了医学人工智能(AI)在临床应用中的挑战,特别分析了AI与临床医生在决策方式上的根本不同。如何更好地将AI技术与人类专家的思维过程相结合,不仅影响AI在医疗中的实际应用效果,也关系到患者的安全和医疗决策的准确性。理解AI与人类认知之间的差异,有助于思考如何在未来的医学AI研究中缩小技术与人类认知之间的差距。

01

引言

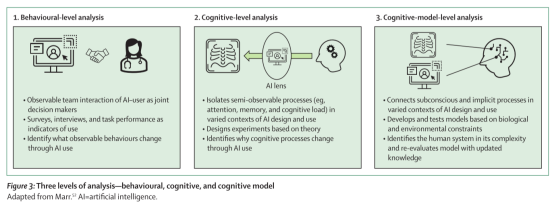

近期, The Lancet Digital Health杂志刊登了阿德莱德大学Lana Tikhomirov团队有关医学人工智能(AI)在临床决策中的整合问题。文章指出,AI系统在医学诊断领域(特别是放射学领域)的发展和商业化进程极为迅速,尤其在美国,已有超过350种医学AI系统获得美国食品药品监督管理局(FDA)的批准。然而,技术的发展远超出人们对其临床价值的理解,这种脱节被称为“AI鸿沟”(AI chasm)。文中指出,AI技术的实施往往面临技术和后勤上的问题,导致其在高风险领域(如医学决策)中的应用研究相对匮乏。因此,文章认为要弥合这一鸿沟,必须从认知科学和人为因素的角度去研究临床医生的决策过程,特别是如何与AI交互。

02

研究背景

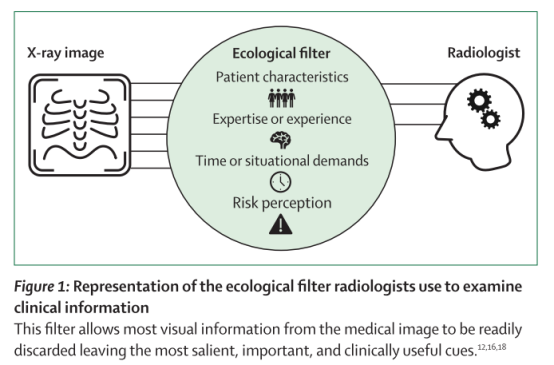

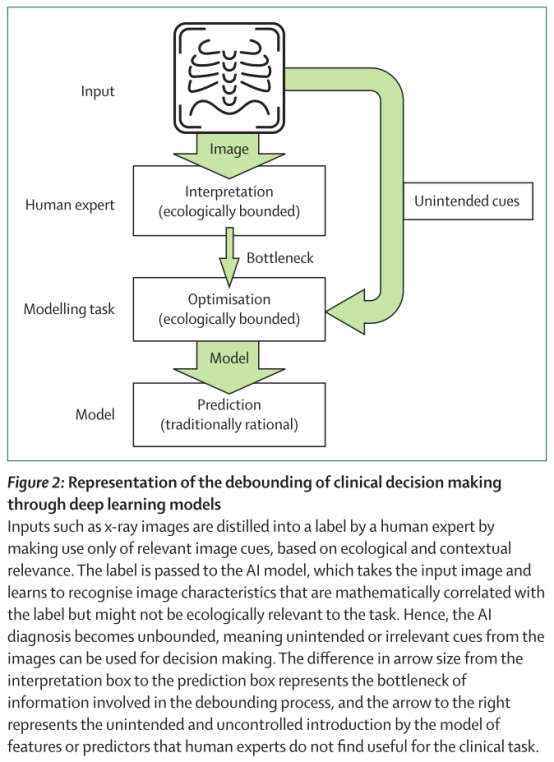

文章着重于描述临床医生(特别是放射科医生)和AI模型在决策方式上的差异。放射科医生的决策是基于感知的线索利用(cue utilisation),这些线索是来自临床环境的感官信号,帮助医生迅速做出诊断判断。相较之下,AI模型的决策是基于数据驱动的相关性分析,这些模型不受临床环境的限制,可能会在做决策时使用与任务无关的特征(如非相关的影像标记),这与医生的“生态理性”(ecological rationality)截然不同。文章指出,尽管AI能够处理大量信息,但其决策往往脱离了生态上下文,即在临床上医生认为相关的信息。在这种情况下,AI容易做出过度依赖训练数据的“快捷学习”(shortcut learning),这使得它在特定环境中的表现可能优于医生,但在临床实际应用中可能会遇到问题。

03

研究对象和研究方法

本研究的对象主要聚焦于临床医生,特别是放射科医生。在AI训练过程中,模型通过数学方法来尽量减少预测错误,试图根据输入的数据(比如医学影像)来预测病理结果。然而,这个过程并不总是和临床医生的判断一致。AI模型在训练时,可能利用了一些与实际临床决策无关的特征,比如影像上的标记或医院的某些流程痕迹,这种现象被称为使用了“非生态理性”特征。

研究采用了认知科学中的生态理性理论,强调医生在复杂环境下如何使用感知线索做出诊断决定。文章通过放射学中的典型案例研究,分析医生如何基于环境上下文和经验使用有限信息做出准确判断;AI模型则通过大量数据训练,使用所有可用的特征做出判断。研究通过理论分析指出,这两者在决策方式上的根本差异可能会导致AI与医生的协作出现问题。

在实验设计上,研究并未专注于对AI的技术性能分析,而是从认知角度探讨了AI系统与医生在决策过程中如何互动,尤其是AI如何处理数据特征、如何展示决策结果,以及医生如何理解这些结果。

04

研究结果与结论

文章的主要结论指出,临床医生和AI系统在决策方式上有显著性差异。AI系统依靠数据驱动的相关性分析来得出结论,而临床医生则通过经验和环境线索做出判断。因此,AI与医生的合作不仅是简单的“团队配合”,而是一个更复杂的认知问题。AI在决策时缺乏医生的情境意识,无法像人类那样筛选无关信息,也缺乏对错误信息的怀疑能力(即“认知谦逊”)。因此,AI的引入可能导致医生过度依赖AI(盲目信任)或完全忽视AI的建议。

文章还指出,目前对AI可解释性的研究较为有限。解释性人工智能(XAI)试图向用户展示AI决策的逻辑,但由于AI和医生在决策目标和逻辑上的差异,现有的解释方式难以真正帮助医生理解AI的工作机制。特别是这些解释往往过于简单,可能让医生对AI的能力产生误解或过度信任。

图3 通过深度学习模型来表示临床决策的界限

05

研究亮点

揭示了临床医生与AI的认知差异: 文章通过认知科学的视角,强调了临床医生依赖感知线索和环境上下文做出诊断决策的“生态理性”,而AI模型则依赖数据训练,基于相关性分析做出决策,称为“传统理性”。这种根本性的决策逻辑差异,可导致医生与AI在协作中产生误解和潜在风险。

提出了“决策去边界化”概念: 文章引入了“去边界化”(debounding)的概念,指出AI在 训练中使用了很多与临床无关的特征(如影像标记或医院工艺处理痕迹)做出预测,导致其决策脱离了临床上下文。 这为AI在医学领域的应用提供了一个新的视角,提醒开发者注意AI训练中的上下文重要性。

批判了现有的AI可解释性方法: 文章指出当前的XAI在临床中的局限性,认为AI与医生的决策逻辑不同,简单的解释方式难以真正帮助医生理解AI的运作机制。这一观点对未来AI系统的开发提出了重要挑战,提示需要更加深入的认知研究来改进可解释性。

呼吁将认知科学融入AI开发与应用: 文章强调,AI系统的开发和使用不仅仅是技术问题,还应重视医生的认知过程。作者建议未来的研究应从医生的认知过程出发,设计更符合临床实际需求的AI系统,以增强其在高风险医疗环境中的安全性和有效性。

文献来源:

Tikhomirov L ,Semmler C ,McCradden M , et al. Medical artificial intelligence for clinicians: the lost cognitive perspective[J]. The Lancet. Digital Health, 2024, 6 (8): e589-e594.

原文链接:

https://www.thelancet.com/journals/landig/article/PIIS2589-7500(24)00095-5/fulltext

分享者简介 ✦

邓茂林

重庆大学智能肿瘤学教育部医药基础研究创新中心2024级生物与医药硕士

编辑|曾海蓉 李劲

链接:http://www.lewenyixue.com/2024/10/17/%E5%89%8D%E6%B2%BF%E5%88%86%E4%BA%AB%20%7C%E5%8C%BB%E5%AD%A6%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD%E4%B8%8E%E4%B8%B4%E5%BA%8A%E5%86%B3%E7%AD%96%E7%9A%84%E6%8C%91%E6%88%98/

赶快来坐沙发